Qwen3-Coder解读:性能剖析、价格探秘与上手指南

Qwen3-Coder发布解读,汇总最新新闻,分析其性能、价格及使用方式,助你秒懂这款新一代开源编程大模型。

引言

今年 7 月,阿里巴巴 Qwen 团队发布了 Qwen3-Coder,一款号称能够媲美 Claude Sonnet 4、专为代码生成与智能体开发场景设计的大模型。对于编程人群来说,AI 助理“能不能真上岗”、落地体验如何、价格几何、用起来是不是够省心,是绕不开的现实问题。作为一名亲身体验、长期关注 LLM 演进和开源社区动态的开发者,我很乐意聊聊这款引发高度关注的重磅新品。

一、Qwen3-Coder 是什么?

让我们先厘清产品定位。Qwen3-Coder 属于 Qwen3 系列的代码专家模型(Agentic Code LLM),当前最强版本为“Qwen3-Coder-480B-A35B-Instruct”,参数量达到 4800 亿,总体是 MoE(Mixture-of-Experts)架构,推理时激活的主要参数为 350 亿。

- 巨大的上下文能力:原生支持 256K tokens 上下文,通过 Yarn 优化可达 100 万 token,这对需要全局理解代码仓库、代码依赖分析的复杂工程场景极为关键。

- 多语言支持:内置 358 种编程语言,涵盖主流业务开发环境。

- 智能体级任务专攻:不仅提升了传统的代码补全、bug 修复、注释生成等功能,更特别针对“Agentic Coding”、“agent 操作浏览器”、“工具多轮联动”等典型大项目场景做过强化(如 SWE-Bench、BFCL 测试集均排名前列)。

- 代码强化学习驱动:训练时引入大规模真实代码测试用例,通过 Code RL 与 Agent RL(多回合智能体交互)提升代码执行成功率,拥有极强实际落地表现。

二、性能对比与评测亮点

对比竞品表现与创新点

根据官方评测和社区反馈,Qwen3-Coder 在代码生成、复杂智能体链路等场景上,和闭源标杆 Claude Sonnet 4 几乎旗鼓相当,甚至在部分开源任务项目上实现了超越(如 SWE-Bench Verified 测试集)。社区实测(dev.to)还提及,Qwen3 系列在 Aider coding benchmark 中,甚至“非思考模式”就能挑战(甚至超越)Claude 的高端大模型,显示其在实际项目中的出色兼容与泛用性。

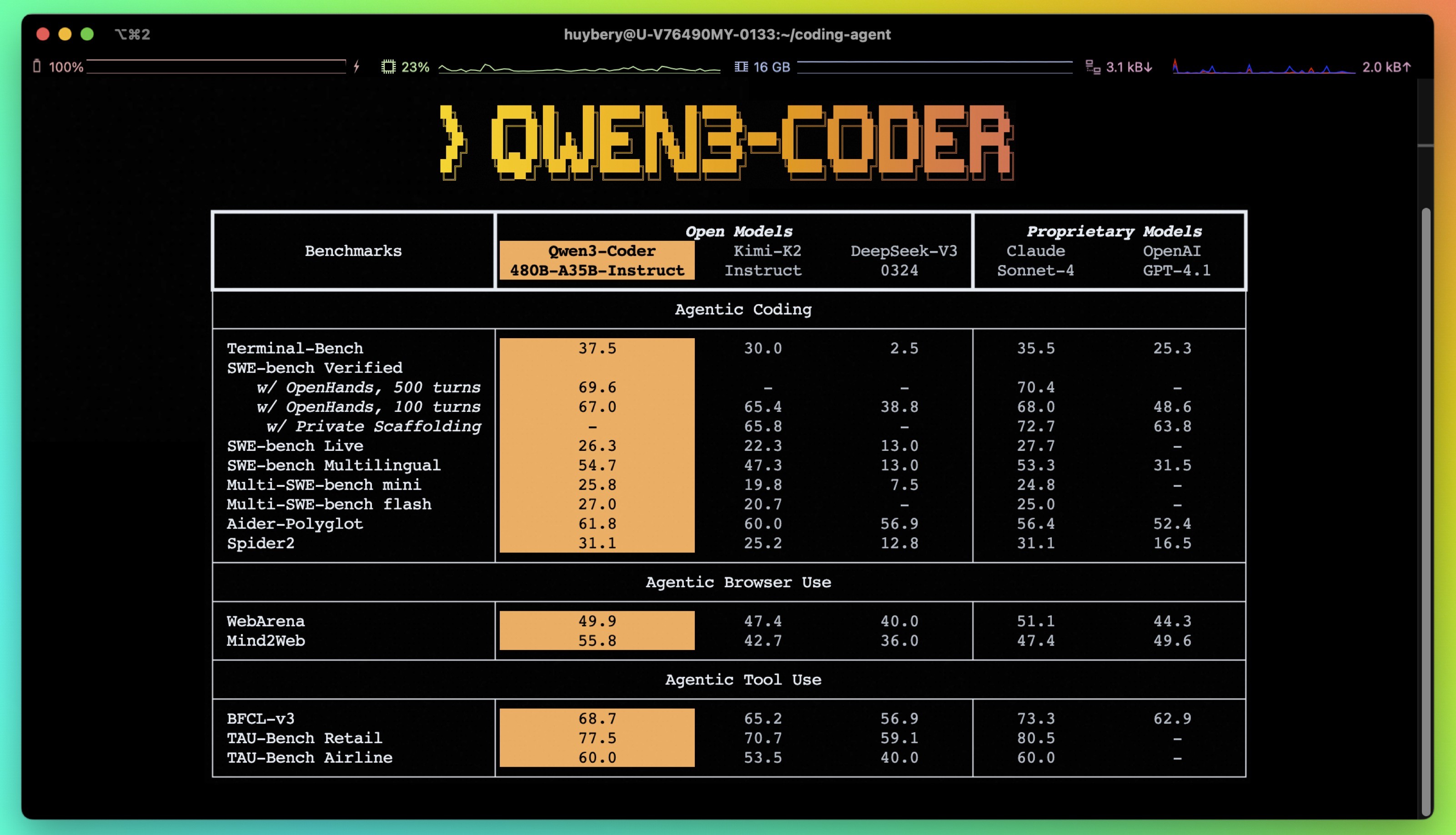

部分核心指标如下:

Qwen3-Coder 在多个 Agentic 基准测试中表现优异,尤其是在Agentic Coding方面,其在 SWE-bench Verified (w/ OpenHands, 500 turns)上达到 69.6,与 Claude Sonnet-4 的 70.4(差距很小),并且超过了最近的 Kimi-K2 的 65.4;在 SWE-bench Verified (w/ OpenHands, 100 turns)上,Qwen3-Coder 为 67.0,也接近 Claude Sonnet-4 的 68.0。在Agentic Browser Use中,Qwen3-Coder 的 WebArena 评分为 49.9,Mind2Web 评分为 55.8,在 WebArena 上略低于 Claude Sonnet-4(51.1),但在 Mind2Web 上则显著高于所有其他模型,包括 Claude Sonnet-4(47.4)和 GPT-4.1(49.6)。在Agentic Tool Use方面,Qwen3-Coder 在 TAU-Bench Retail 上达到 77.5,虽然略低于 Claude Sonnet-4 的 80.5,但仍是开放模型中表现最佳的。

创新机制——混合推理与思考预算

Qwen3 系列最大特色之一是“混合推理模式”:即在模型使用时,开发者可以根据任务复杂度选择“思想模式”或“非思考模式”。简单的任务使用“快思考”,复杂的问题或需要深入链式推理(CoT)时,自动进入“慢思考”。(需要注意截至这个文章发表,qwen3-coder不支持思考模式)

- “快响应”意味着节省推理资源,更便于流式提示和高频补全;

- “慢推理”则能在多步运算、代码逻辑等场景产生接近人脑“分步骤缜密思考”的结果。 这一点在 API 控制参数、vllm/Sglang 部署等场景下可以灵活切换,真正做到了让 AI“聪明把力用在刀刃上”,开发者能精细地权衡“成本—延迟—解题质量”三者关系。

工具链生态与插件兼容

Qwen3-Coder 为 AI 编程智能体生态量身打造工具——Qwen Code CLI(fork 自 Gemini CLI),以及对 Claude Code、Cline 等开发者常用工具的全面适配,极大降低了用户实际落地门槛。你既可以用官方 CLI 命令行,也能通过简单配置 API key 和 Base URL,接入现有诸如 Cline、Claude Code 等流行的 agent 工作流,灵活度极高。

三、价格体系与算力门槛

定价体系分析

本次 Qwen3-Coder 官方主推的是 API 接口调用,暂未推出面向个人的月付套餐(多为按 Token 计费)。阿里云 API 或通过 OpenRouter 平台调用,价格在当前主流 AI 编程工具中并不便宜,中大型项目很容易一会儿“烧”几十、几百元(V2EX 社区实际体验)有不少网友反馈,几个大任务就消耗了几十元,甚至赠送 100 万 Token 额度一会儿用完且多轮操作烧钱飞快)。

- 官方偶有免费额度赠送(一般约 100 万 token 每 ID),但用量和任务复杂度相关,token 消耗很快。

- 公有云定价使用阶梯定价,256K 之前的价格较为便宜,大于 256K 时会比 claude 4 sonnet 更加昂贵。

- 没有月费包、套餐包,按 Token 计费对企业大包量需求更友好,对个人开发者相对不够亲民。

官方已经开启了限时折扣。

2025 年 7 月 23 日至 8 月 23 日限时折扣

2025 年 7 月 23 日至 8 月 23 日限时折扣

| 上下文长度 | input 价格 (元/百万 tokens) 定价 | input 价格 (元/百万 tokens) 限时优惠 | input 价格 (元/百万 tokens) 折扣率 | output 价格 (元/百万 tokens) 定价 | output 价格 (元/百万 tokens) 限时优惠 | output 价格 (元/百万 tokens) 折扣率 |

|---|---|---|---|---|---|---|

| 0-32K | 4 | / | / | 16 | / | / |

| 32K-128K | 6 | 4.2 | 30% ↓ | 24 | 16.8 | 30% ↓ |

| 128K-256K | 10 | 5 | 50% ↓ | 40 | 20 | 50% ↓ |

| 256K-1M | 20 | 10 | 50% ↓ | 200 | 100 | 50% ↓ |

此外,官方的lingma插件(当前个人用户限免)已经提供qwen3-coder。以及魔搭社区的推理服务,每天免费 2000 次请求(https://modelscope.cn/models/Qwen/Qwen3-Coder-480B-A35B-Instruct)。

部署、硬件成本

- 由于基于 MoE 加动态量化等新技术,480B 参数满血模型在 4bit 下约需 270GB VRAM(专业显卡/高性能本地算力),而本地端部署建议等更小尺寸模型发布——当前主力适合云端 API 或高算力服务器。

- 社区已有人在 M3 Ultra 512GB 或者 RTX 3090 双卡等高端配置尝试,本地量化推理有可能,但对普通个人用户门槛不低。

- 预计相对小参数量模型(后续可能推 32B/30B 等)会陆续上线,更适合个人用户日常开发与本地 IDE 集成。

四、如何实际使用 Qwen3-Coder

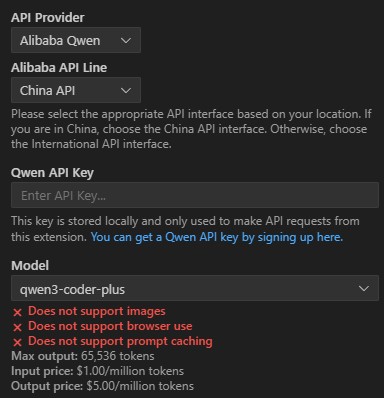

1. 官方 API 调用(阿里云 Model Studio)

- 注册阿里云账号,进入Model Studio 控制台,申请 Qwen3-Coder API Key。

- 选择模型版本(如 480B-A35B-Instruct),即可获得 API 调用权限。

- 编写代码时,用标准的 OpenAI SDK 进行调用,设置好 base_url 为

https://dashscope-intl.aliyuncs.com/compatible-mode/v1,model 参数设为qwen3-coder-plus,并配置 DASHSCOPE_API_KEY 环境变量。

代码示例:

import os

from openai import OpenAI

client = OpenAI(

api_key=os.getenv("DASHSCOPE_API_KEY"),

base_url="https://dashscope-intl.aliyuncs.com/compatible-mode/v1",

)

prompt = "帮我写一个在线书店的网页代码"

completion = client.chat.completions.create(

model="qwen3-coder-plus",

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": prompt}

],

)

print(completion.choices[0].message.content.strip())

2. Qwen Code& Claude Code 工具链

- Qwen Code CLI(安装:

npm i -g @qwen-code/qwen-code),适合喜欢终端交互、项目分析、多项目代码批量操作的开发者。 - 可将 Qwen3-Coder 作为 Claude Code 后端(通过 API 兼容代理方式),即将 BaseUrl 设为阿里云的地址,token 填自己的 API Key,即可实现同一种代码助手控制台,多模型无缝切换。

- 对 Cline、ollama 等开源本地框架支持,未来支持个人本地或多机并行部署有望。

3. Cline 等其他社区 AI 编程插件

和以上类似,直接选择 OpenAI 兼容模式,修改 base 和 apiKey 即可。

Cline 的 3.20.0 版本已经支持 Qwen 的模型提供商。

4. 社区生态

- 模型权重已上传至HuggingFace 和 ModelScope。开发者可自定义二次开发或小型本地化启动。

五、体验、适用场景与不足

体验与讨论

- 正向体验:大模型对复杂需求型代码、长链路代码项目表现优异,协作、联动、调用外部工具能力强。多用于团队代码审查、自动化 refactoring、大规模代码生成等环节。

- 槽点反馈:1)价格偏高,免费额度体验有限,个人用户慎用大任务以免欠费;2)C 端场景下代码审美、前端设计等表现仍不及 Claude/Gemini,主打后端工程和自动化工具开发优先;3)部分第三方 IDE、插件的兼容性等待跟进。

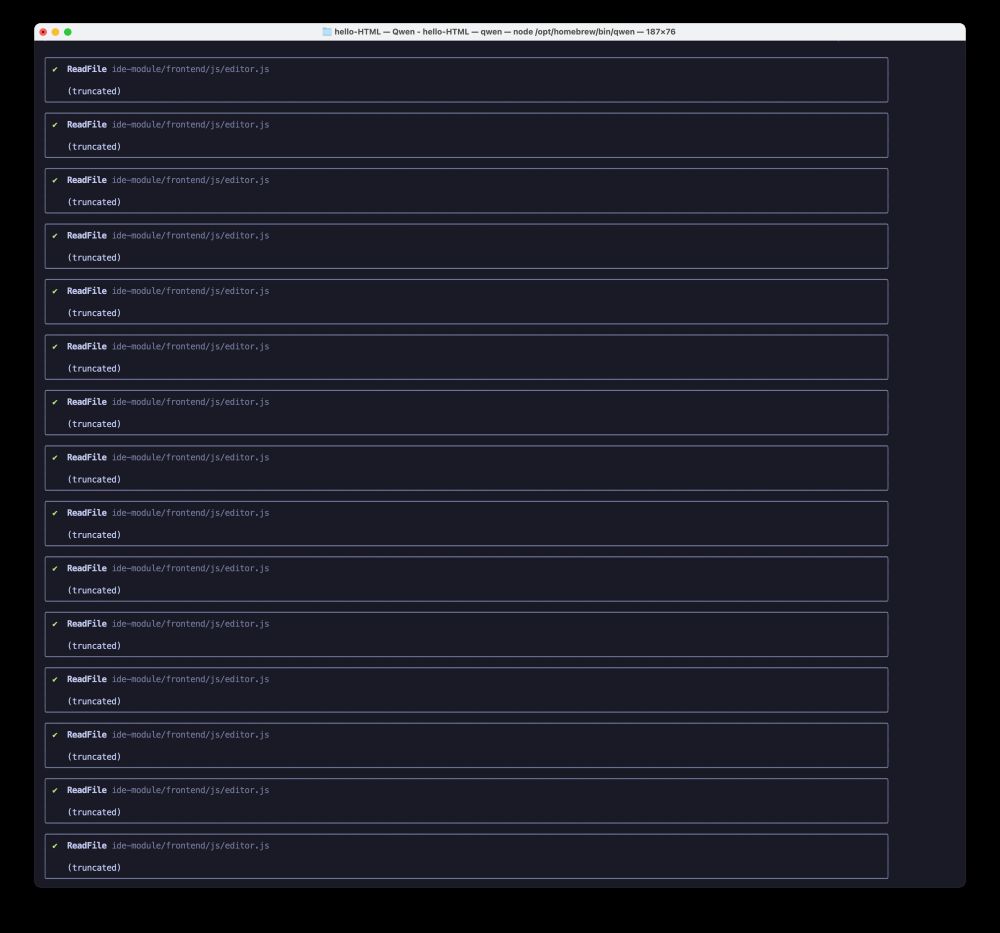

截至这篇文章发布时,不少用户反馈在该模型在工具调用上还存在一些 bug 会反复调用读取文件的 tool 导致 token 消耗过快。

https://github.com/QwenLM/qwen-code/issues/66

https://github.com/QwenLM/qwen-code/issues/66

虽然这是在qwen-code(CLI 编程工具)里提到的,但是其他使用插件+API 的用户一样遇到了类似问题。

最适合的场景

- 中大型项目、Agent 开发、自动化工具链、DevOps、CI/CD 场景

- 需要长上下文记忆、仓库级代码重构与静态分析的复杂工程

未来展望

预期后续 Qwen3-Coder 将继续发布小尺寸版本,支持更广泛的开发者生态,降低本地部署门槛。同时,配合阿里云生态逐步完善高阶编程智能体、自动化编译环境等能力,“让 AI 写代码”真正进入从“可用”到“好用”的阶段。

结语

Qwen3-Coder 无疑是 2025 年 AI 编码领域最值得关注的创新产品之一。不仅仅是单点代码生成能力的进化,更在支持长链智能体、多轮 Agent 交互落地,实现了开源模型对标全球商用顶流产品的突破。尽管“用起来不便宜”、本地部署门槛高,但它引领的思路——让代码助理“智能上岗”——已经在转变开发范式。对于团队和大项目来说,是一个值得投入和尝鲜的新选择。

FAQ

Q1:Qwen3-Coder 能免费用吗?

目前阿里云 Model Studio 等平台有新用户 100 万 token 的免费额度,但用量很快消耗完。大项目或多次调用需自备经费。

Q2:Qwen3-Coder 支持本地部署吗?门槛高不高?

480B-A35B 当前主要面向高算力服务器(专业 GPU),本地量化部署需 512GB RAM、顶配显卡等。未来更小参数量模型发布,可在主流显卡尝试跑小项目。

Q3:它和 Claude Code、Gemini 等相比如何?

在代码能力、长上下文、多轮 Agent 任务等指标上,与 Claude Sonnet 4、Gemini 2.5 等顶级模型平分秋色。部分基准还实现了超越,尤其是代码生成场景。但在代码美观度、前端生成体验等部分细节需持续提升。

Q4:价格大致多少?怎么避免“烧钱”?

API 一般按输入/输出 Token 计费,价格比主流编程 AI 助手略高。建议大项目用前仔细预估 Token 消耗,最好先在有限场景试用再正式投入——不然一次代码大清理可能就花出去几十元。

参考资料

- Qwen3-Coder 官方博客、API 与代码示例

- V2EX 社区 Qwen3-Coder 发布讨论与价格体验

- Qwen3-235B-A22B 社区评测与基准对比

- RunPod:Qwen3 模型性能及部署建议

- Digialps:Aider coding benchmark 社区实测与调优

- Hugging Face 相关模型下载

(本文基于公开新闻、官方文档及社区用户实测数据整理,欢迎留言交流个人体验与见解。)