智谱AI GLM-4.5模型总览

本文是智谱AI最新发布的GLM-4.5模型的资料整理和介绍,旨在为开发者提供客观、及时的技术参考。

引言

最近这段时间真的是中国的开源大模型井喷的时间,随着 Kimi 发布 K2,qwen 发布 qwen3-coder,中国的另一个久负盛名的厂商智谱 AI(Zhipu AI)发布了 GLM-4.5 模型。相比之下某家以 open 开头的大模型公司的开源模型还在路上。

2025 年 7 月 28 日,开源的人工智能基础模型领域迎来重要更新,智谱 AI(Zhipu AI)发布了其最新的 GLM-4.5 系列模型。该系列旨在通过技术创新,为开发者社区提供兼具高性能与高效率的开源解决方案。本文将结合公开的技术资料与评测数据,对 GLM-4.5 系列的核心特性、性能表现进行梳理与分析。

主体

一、模型架构与参数

GLM-4.5 系列包含两款核心模型,均采用混合专家(Mixture of Experts, MoE)架构,旨在平衡模型规模与计算效率。

| 模型 | 总参数 | 激活参数 | 核心特点 |

|---|---|---|---|

| GLM-4.5 | 3550 亿 (355B) | 320 亿 (32B) | 顶级性能,面向高复杂度推理与 Agent 任务 |

| GLM-4.5-Air | 1060 亿 (106B) | 120 亿 (12B) | 高效紧凑(还是 MoE 架构),兼容主流消费级硬件 |

MoE 架构通过在推理时仅激活一部分专家(即参数),在保证模型具备大规模参数带来的强大能力的同时,显著降低了实际计算负载。特别是 GLM-4.5-Air,其 12B 的激活参数设计使其能够在消费级 GPU(如 32-64GB 显存)上运行,并通过量化技术进一步降低硬件门槛,推动了高性能大模型在个人开发者与研究者中的普及。

在中国的 deepseek 公司使用 MoE 发布 v3 和 R1 模型并得到比肩商业大模型的性能之后,越来越多的公司开始使用 MoE 架构发布自己的模型。

二、混合推理模式 (Hybrid Reasoning)

GLM-4.5 系列引入了创新的“混合推理”框架,在单一模型中集成了两种工作模式:

- Thinking Mode (思考模式): 专为处理复杂任务设计,支持多步骤推理、工具调用、长期规划和自主 Agent 功能。该模式下,模型能够自主分解任务并执行复杂的认知工作流。

- Non-Thinking Mode (非思考模式): 优化用于即时、无状态的响应,适用于对话、快速问答等低延迟交互场景,提供极快的响应速度。

这种双模式设计使模型能够灵活适应不同应用场景的需求,开发者无需在强推理能力和高交互性之间做出妥协。

三、性能评测与基准表现

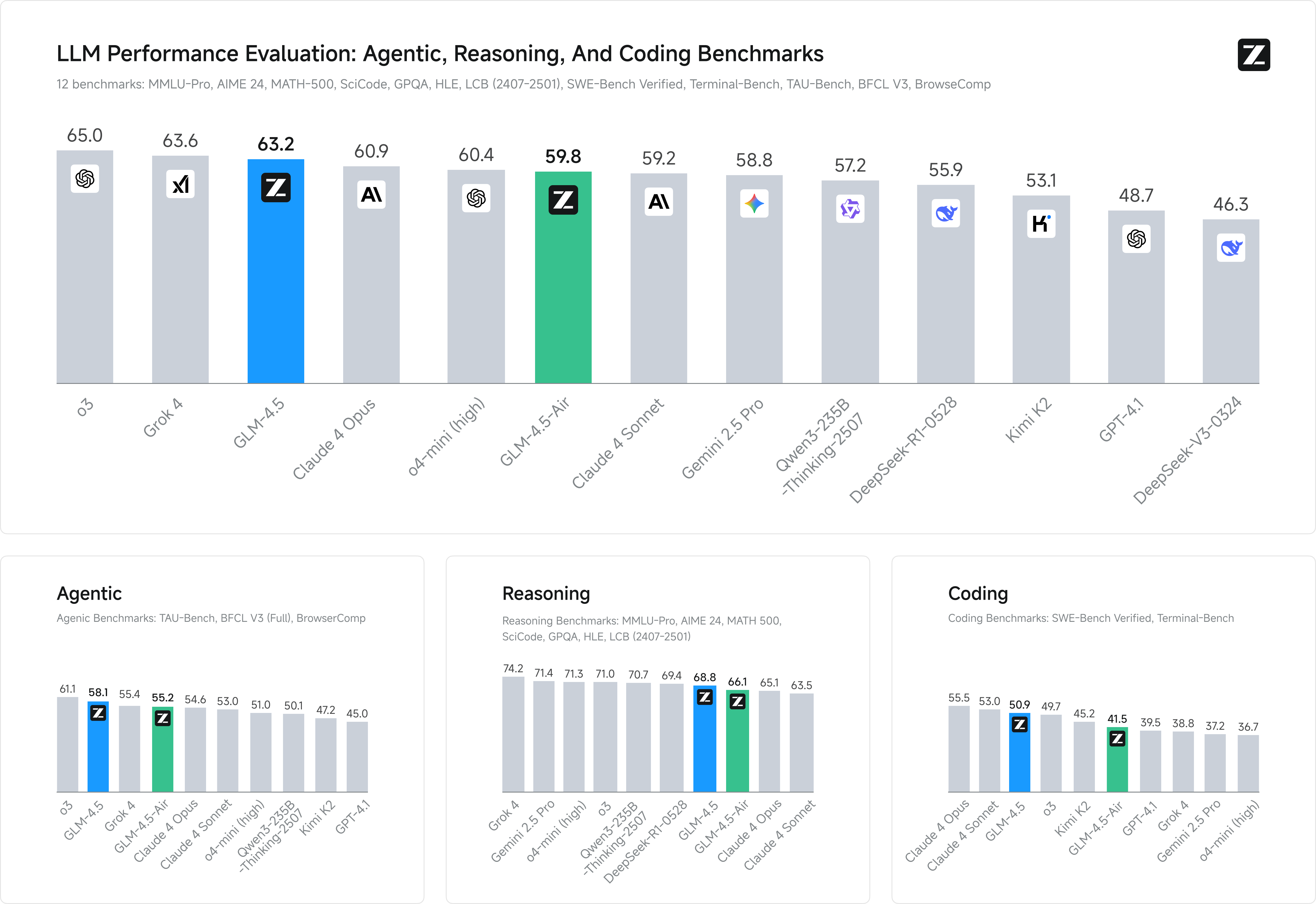

根据 Z.ai 公布的数据,GLM-4.5 系列在 12 个行业标准基准测试(包括 MMLU, GSM8K, HumanEval 等)中表现出色:

- GLM-4.5: 平均得分为63.2,在全球所有模型中排名第三,在开源模型中位列第一。

- GLM-4.5-Air: 平均得分为59.8,在百亿参数规模的模型中处于领先地位。

在特定能力上,GLM-4.5 系列同样表现突出:

- 代码能力: 在 SWE-bench Verified 评测中得分64.2,超越了 GPT-4.1 和 DeepSeek。

- 上下文窗口: 支持高达128k的输入上下文和96k的输出上下文,适用于长文档处理和复杂编程任务。

四、原生 Agent 能力 (Agent-Native Design)

GLM-4.5 将 Agent 的核心功能(如推理、规划、行动)直接构建于模型架构之中,实现了“原生 Agent”能力。这意味着模型能够:

- 自主进行多步骤任务分解与规划。

- 无缝集成和调用外部工具及 API。

- 管理复杂的工作流和数据可视化任务。

- 支持完整的“感知-行动”循环。

这种设计范式简化了 Agent 应用的开发流程,开发者可以减少对外部调度和流程控制代码的依赖,更专注于业务逻辑的实现。

五、效率、速度与开放性

GLM-4.5 系列在推理效率和开放性方面也设定了新的标准:

- 推理速度: 借助多 Token 预测(MTP)和推测解码(Speculative Decoding)等技术,高配版 API 的生成速度超过100 tokens/sec,最高可达200 tokens/sec,相比前代模型提升了 2.5 至 8 倍。

- API 定价: 定价极具竞争力,参考定价表格。使用阶梯定价,最贵的定价每 1M 输入输出为 4 元和 16 元(原价,当前打折),注意带 X 的版本是加速版本,性能应该没有差别。

- 开源协议: 整个系列,包括基础模型、混合推理模型和 FP8 量化版本,均在MIT 许可下完全开源,允许无限制的商业使用和二次开发。

- 生态系统支持: 模型已深度集成到

transformers、vLLM和SGLang等主流 LLM 框架中,并在 GitHub 和 Hugging Face 上提供了完整的代码、工具解析器和推理引擎,方便开发者进行部署、微调和本地化。

六、核心技术创新

GLM-4.5 的性能提升得益于多项技术创新:

- 多 Token 预测 (MTP): 一种用于推测解码的专用层,显著提升了在 CPU 和 GPU 上的推理速度。

- 统一架构: 将推理、编码和多模态感知-行动工作流整合在统一的框架内。

- 大规模预训练: 模型在高达15 万亿Token 的数据集上进行训练,为强大的泛化能力奠定了基础。

- RLHF 与“Slime”系统: 采用先进的强化学习框架(Slime),通过混合同步/异步训练和混合精度 Rollout,高效地对 Agent 流程进行优化。

结语

Zhipu AI 的 GLM-4.5 系列模型在性能、效率和开放性之间取得了显著的平衡,为开源社区提供了一个强大且易于使用的基础模型。其混合推理模式和原生 Agent 能力,为开发下一代智能应用提供了坚实的基础。通过全面的开源和对主流开发生态的支持,GLM-4.5 系列不仅推动了技术边界,也为全球开发者和研究人员创造了新的机遇。

FAQ

1. GLM-4.5 与前代 GLM-4 模型相比有哪些主要改进?

GLM-4.5 在架构上升级为 MoE,大幅提升了参数效率。同时,它引入了混合推理模式,原生集成了 Agent 能力,并在推理速度、工具调用成功率和上下文窗口长度等关键指标上实现了显著提升。

2. 个人开发者是否可以本地部署 GLM-4.5?

是的,GLM-4.5-Air 版本经过优化,可在主流消费级 GPU(32-64GB 显存)上运行。官方已开源所有相关代码和模型权重,并提供了详细的部署文档。

3. 如何体验 GLM-4.5 模型?

用户可以通过官方平台chat.z.ai进行在线体验,或从Hugging Face下载模型权重进行本地部署。其 API 服务也提供了极具竞争力的定价,便于进行大规模实验。

4. GLM-4.5 适合哪些应用场景?

该系列模型特别适用于需要多步推理和规划的 Agent 应用、代码生成与分析、长文档摘要与问答、以及复杂工具链的自动化集成。对于希望构建私有化 LLM 或 Agent 的企业而言,它也是一个理想的选择。